极空间本地大模型上线!内置还有Deepseek满血版!

这段时间各家nas系统都忙着内置大模型。

很多小伙伴不明白内置本地运行的大模型有什么意义,简单点来说,就是给数据比较敏感的用户准备的,如果你就是自己用用,数据不敏感,官网的用起来更快一点。

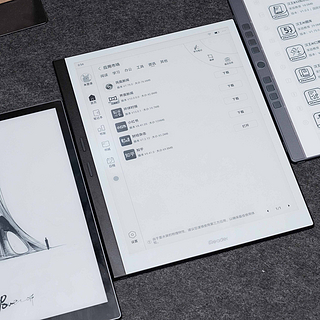

极空间也终于是内置的本地的大模型,从目前的体验上来看,Z423、Q4、Z4 Pro系列系统内已经开始推送了, 像Q2C、Z2 Pro等Arm架构款,暂时应该是与本地内置无缘了。

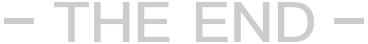

我手上的设备是极空间的Z423旗舰版,本地Deepseek的话,内置有两种规格的大模型,7B和14B,像Q4和Z4 Pro就只有1.5B和7B。从实际体验上来说,7B的输出速度肯定是比14B要快的,但是7B的推理效果是明显不如14B的。

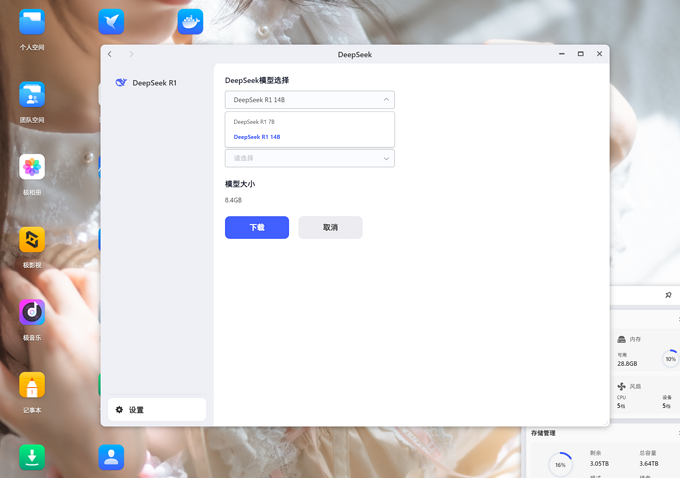

我这里也是部署了docker版本的Ollama,说实话,前前后后试了五个问题,无论是7B还是14B模型,极空间自带的这个Deepseek输出速度上都要比docker版本快上不少。极空间是对这个应用做了什么特殊的优化么?

除了本地运行的大模型之外,极空间的AI助手中还有接入云端满血的Deepseek V3,从实际的使用上来说,这个倒不会像官网那样经常无响应,整体的体验还是不错的。毕竟这个ds满血版的服务是免费的!

并且这个云端满血的DS是不分机型都可以使用,不管是Q2C、Z2 Pro还是Z423都是可以使用的。并且是不限额度,有一说一还是挺爽的。

不知道各位小伙伴怎么看待呢?

牧草流烟

校验提示文案

太阳花向暖

校验提示文案

一一去太空了

校验提示文案

孤岛Chou

校验提示文案

孤岛Chou

校验提示文案

一一去太空了

校验提示文案

太阳花向暖

校验提示文案

牧草流烟

校验提示文案