用 Ultra245K 搭建本地 AI 模型,性价比拉满!

大家好,我是热衷于探索各类科技产品的科技博主。最近 AI 大火,很多朋友都想搭建自己的本地 AI 模型,今天就来给大伙分享我用 Intel Ultra245K CPU 搭建 DeepSeek 模型的经验,不仅能解决云端服务不稳定的困扰,性价比还超高!

为啥选 Ultra245K

咱都知道,本地化 AI 推理会碰到算力难题。用 GPU 吧,7B 模型就得占 5GB 显存,显卡基本就没法干别的;用 CPU 呢,计算负载又会让系统卡顿。而 Ultra245K 的核显就很巧妙,它能利用主机内存,还能和 CPU 独立运行,对整机性能影响小。而且现在 Ultra 系列 CPU 降价,Ultra245K 性价比直接起飞。

装机方案超省钱

我的装机配置主打性价比。CPU 选 Intel Ultra245K,它包装精致,小黑盒正面有透明窗,能直接看到 CPU,还印有型号、序列号和二维码,背面设计方便装机,通过凹槽就能确定安装方向。

主板用铭宣终结者 B860M,黑白色调,12 相供电,能稳定支持 CPU。它支持双通道 4 根 DDR5 内存,最大到 128GB,还原生支持 7000Mhz DDR5 内存频率,高负载场景下性能提升明显。

内存是光威龙武 DDR5 16*2 6000mhz 套条,活动价 400 多就能拿下。机箱选拓扑龙开放式机箱,只要 30 块,比鞋盒强多了。电源是爱国者 EP650 650w 全模组电源,200 块左右,供电稳定。

性能实测超给力

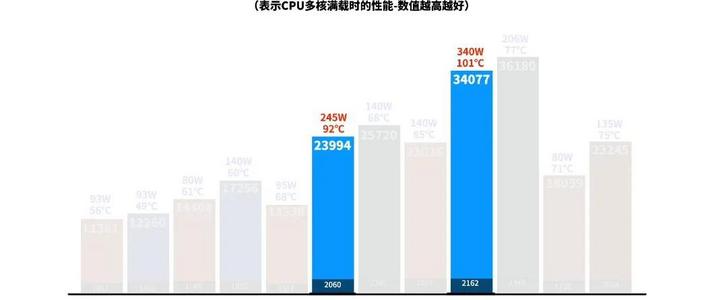

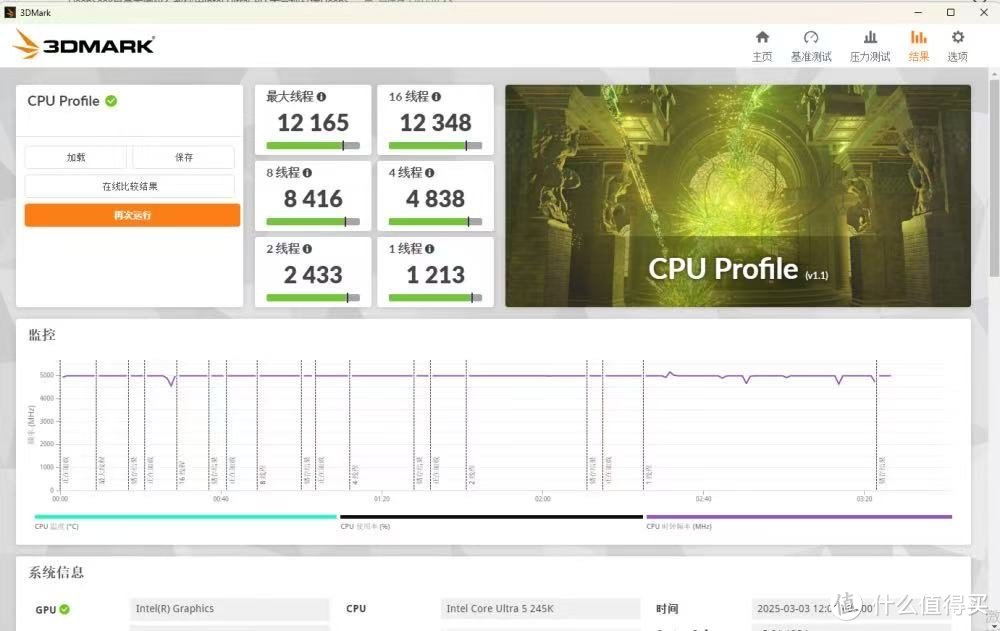

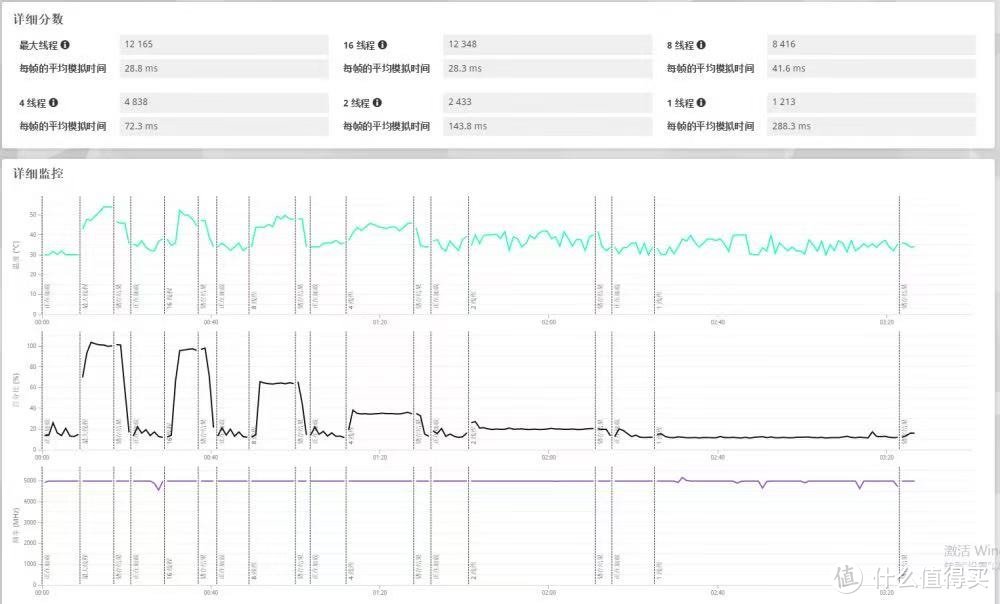

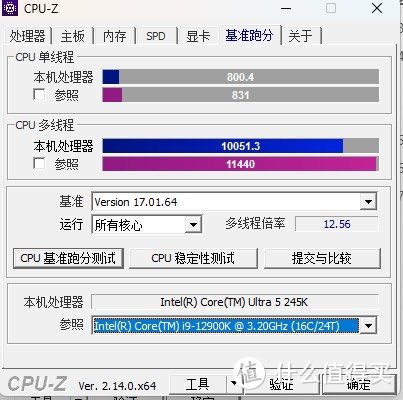

装机完成后,我对 CPU 和核显进行了性能测试。3DMark CPU Profile 测试里,Ultra245K 单线程分数 1213 分,多任务并行时最大线程得分 12348 分,处理单核心任务和多任务都很出色。CPU-Z 测试中,单核心 800 分,多核心 10051 分,多核心成绩几乎和曾经的高端处理器 12900K 持平。

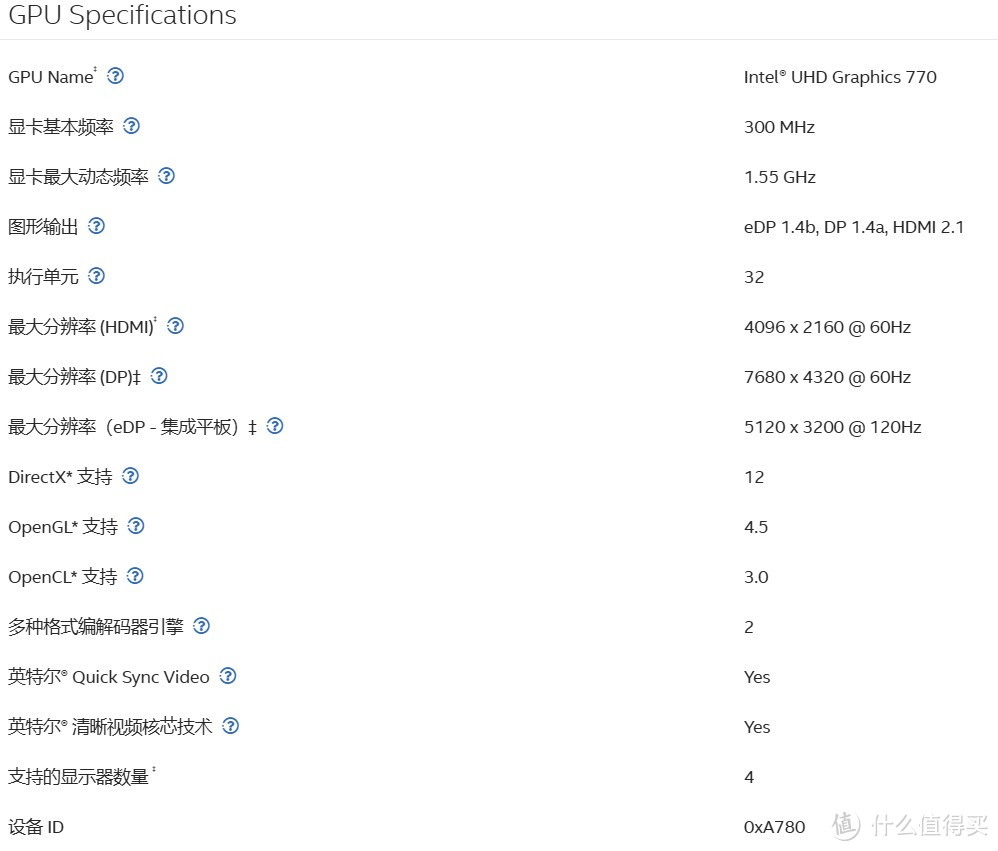

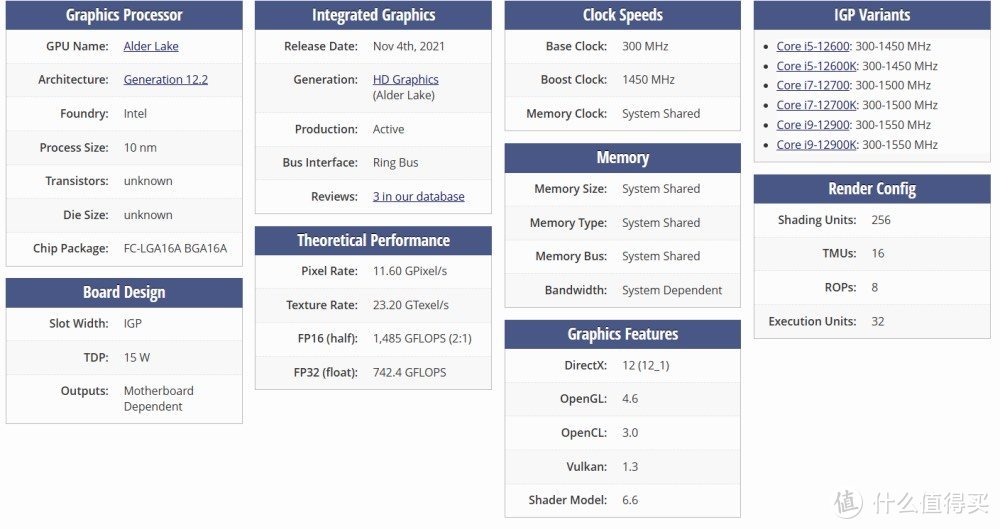

核显方面,相比 14 代的 HD770,Ultra245K 升级到 4Xe-core 新式核显,有 4 个 1.9GHz 的 Xecore,支持 8K 60hz 编解码,AI 算力在 int8 精度下达到 8TOPS,是 HD770 的 2.6 倍。而且支持英特尔 DLBoost 深度学习加速技术,int4 量化部署时算力为 16TOPS,满足大模型端侧部署的算力要求。

部署过程超详细

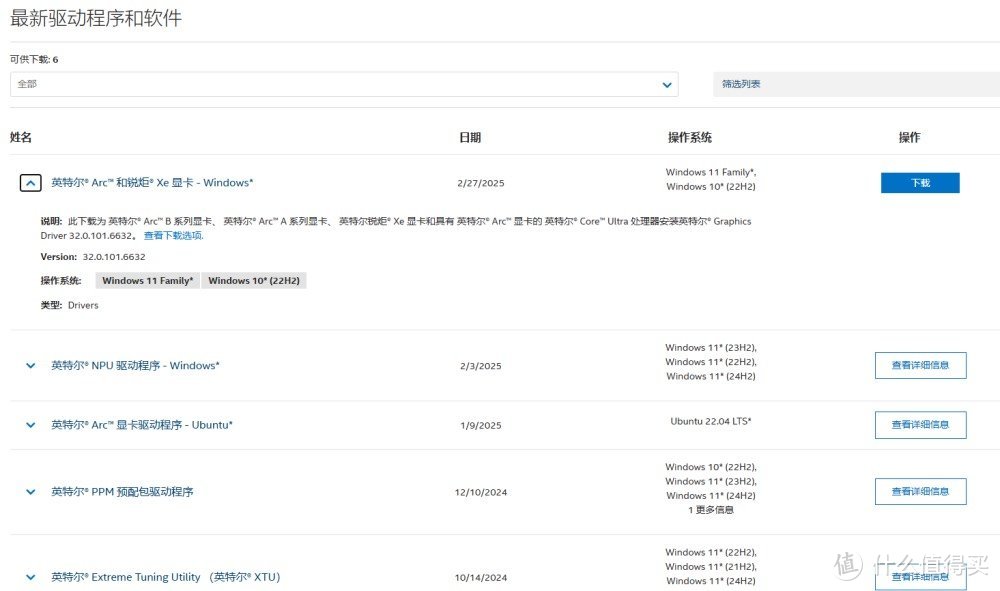

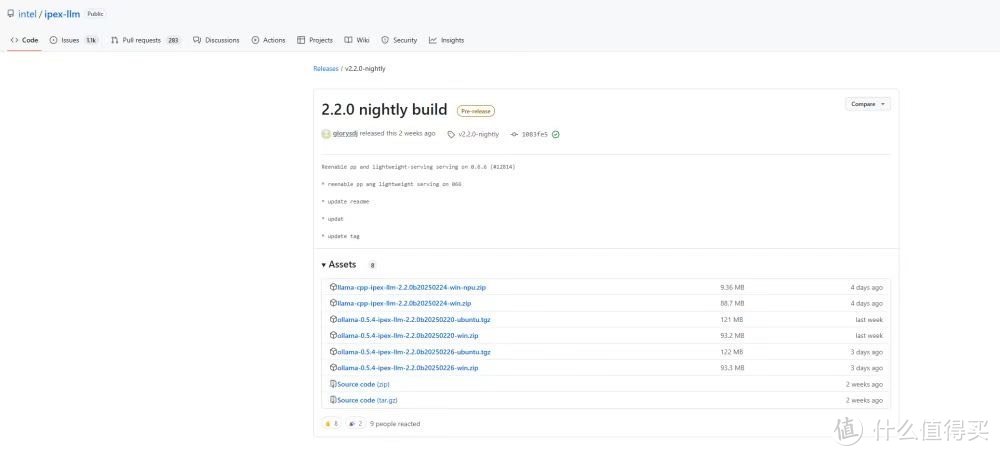

1. 安装依赖软件:先去英特尔官网下载最新的 GPU 驱动,根据系统选择就行。然后去https://github.com/intel/ipex-llm/releases/tag/v2.2.0-nightly下载 ipex-llm ollama 部署包,解压备用。

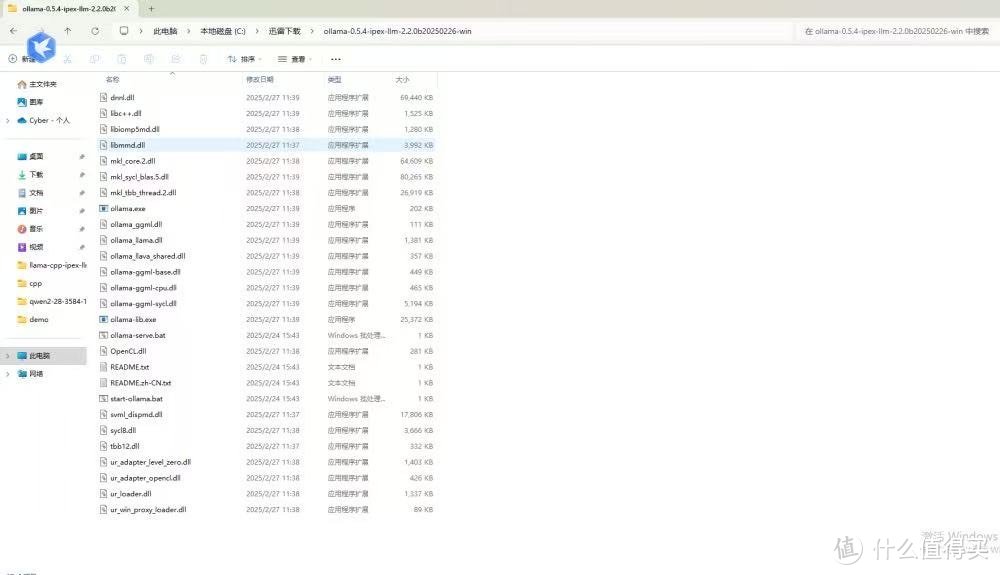

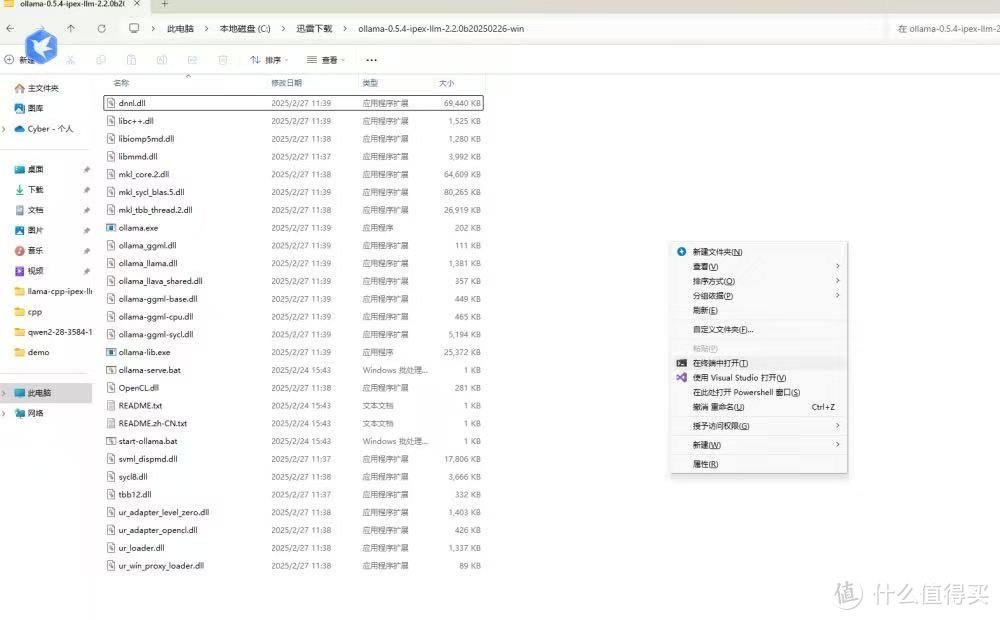

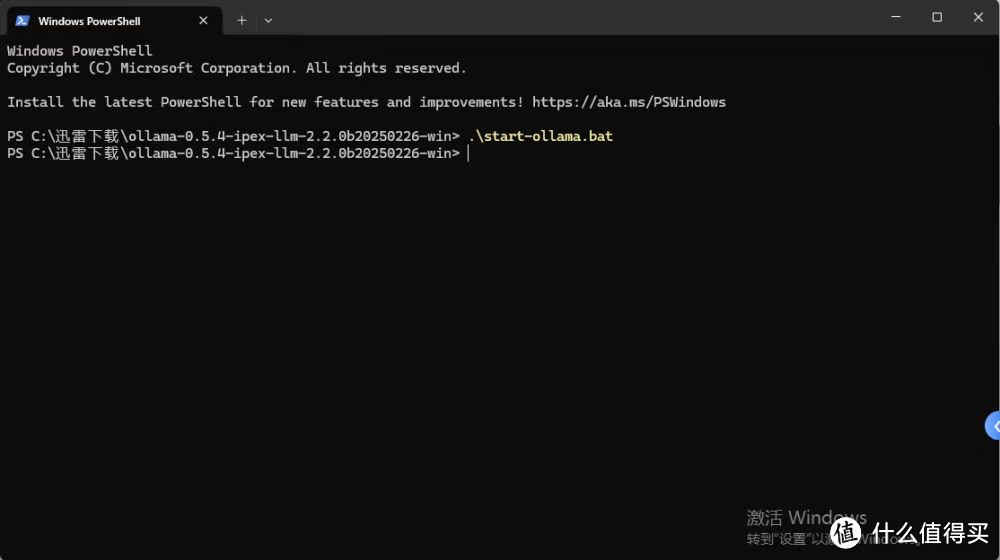

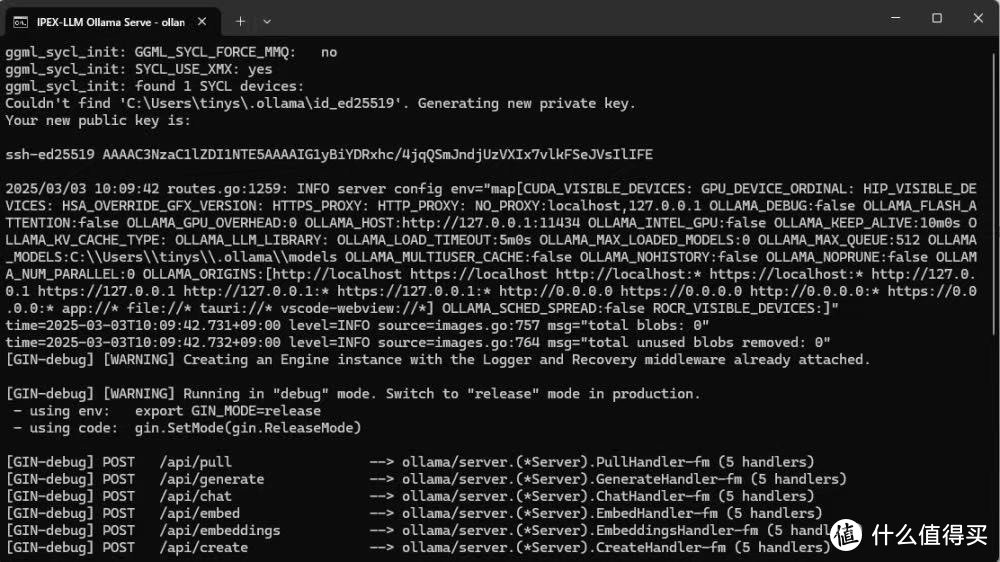

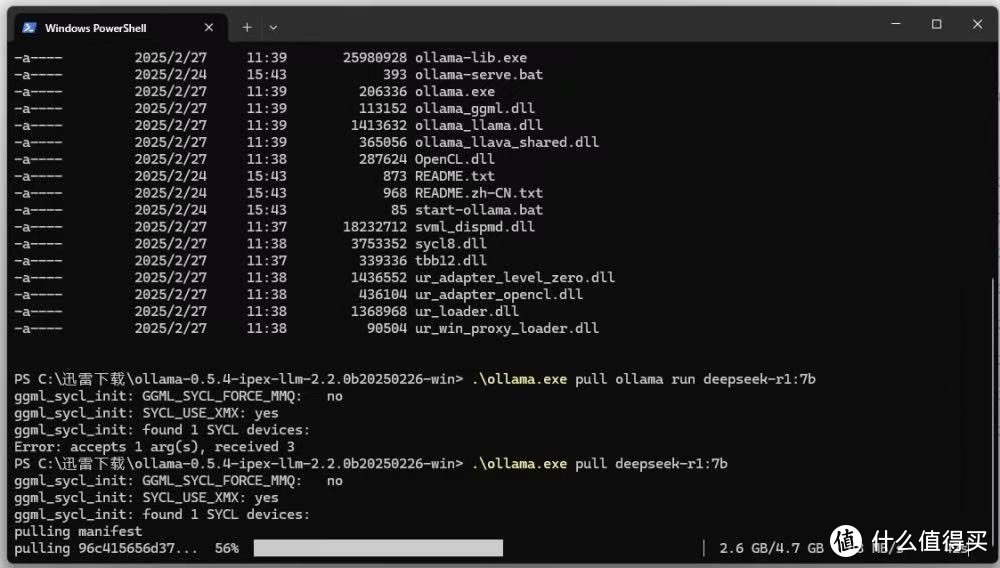

2. Ollama 启动和模型部署:在解压后的文件夹里按住 Shift + 右键,选在终端中打开,输入./start-ollama.bat 启动 Ollama,会弹出满是日志的命令行窗口,别关它。接着在窗口里输入.ollama.exe pull deepseek-r1:7b 下载模型,等下载完成。

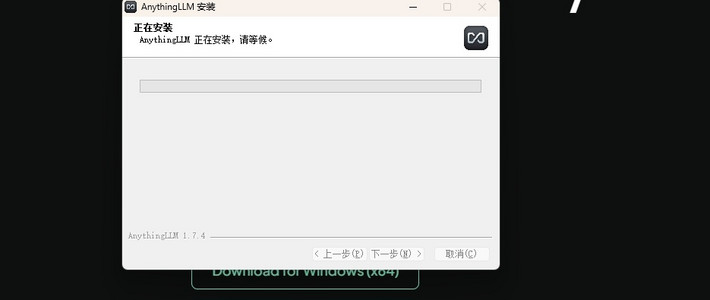

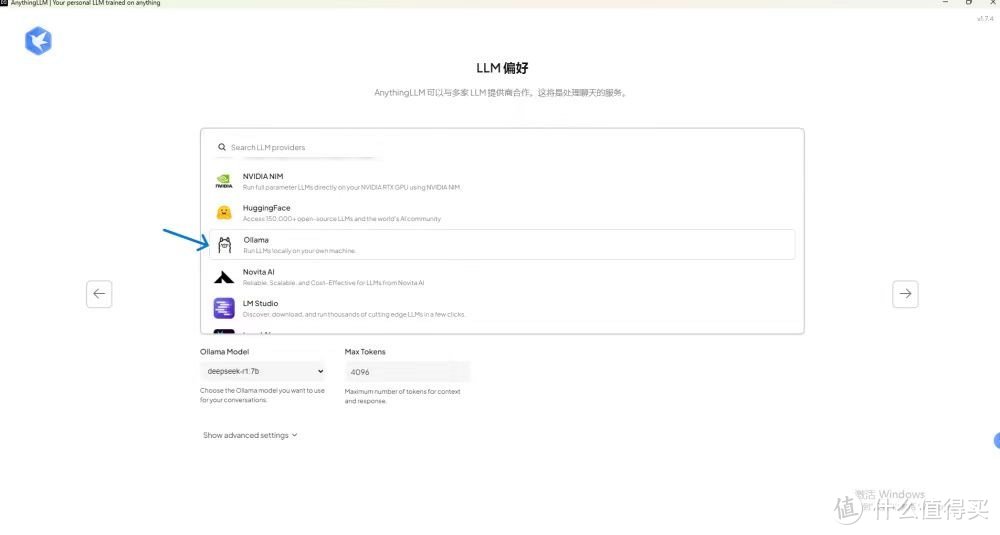

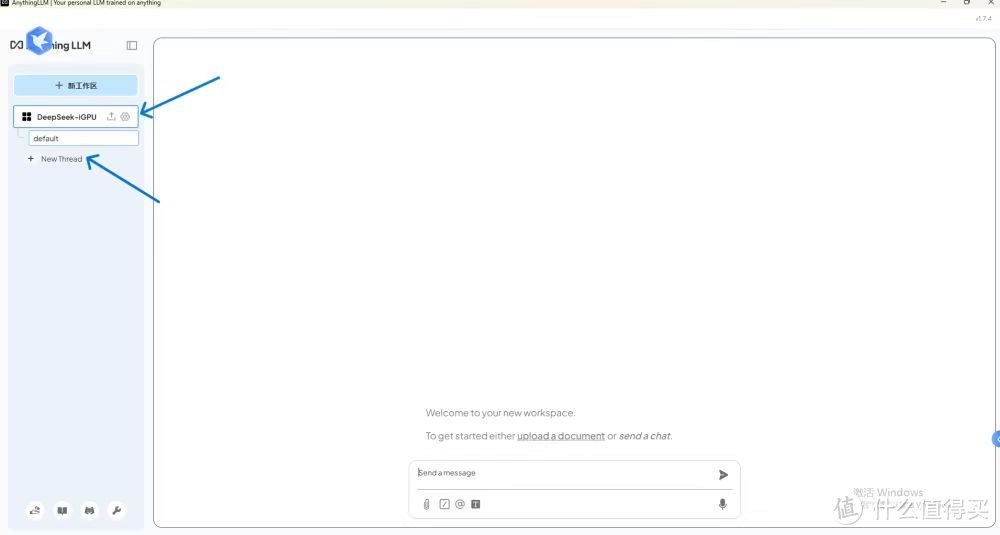

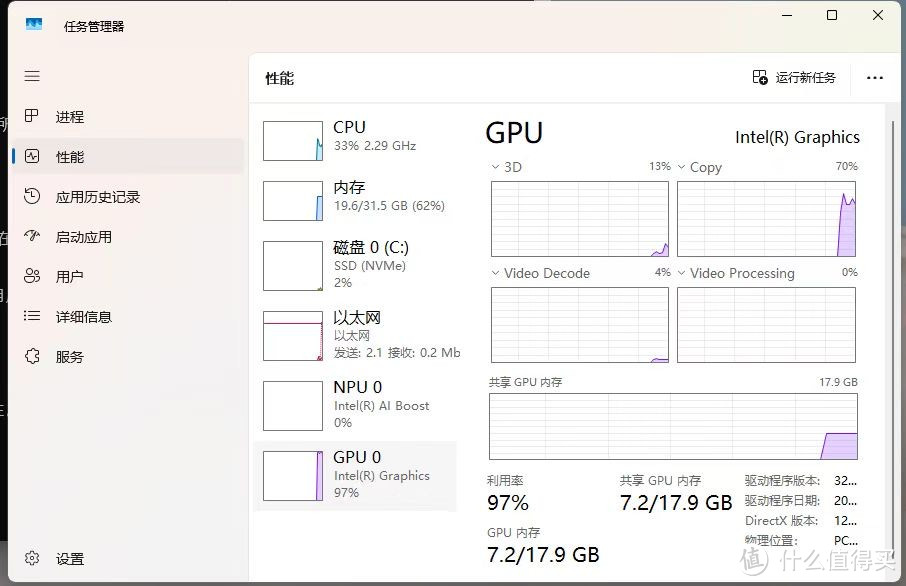

3. 启动大模型前端:模型下好后,用命令行对话不太方便,我们用 AnythingLLM 软件。去官网下载安装,安装好打开,在模型选择位置选 ollama,就能看到 DeepSeekR1 模型。创建个工作区,比如 “DeepSeek-iGPU” ,选好工作区后点 NewThread 开启新对话,就能和模型聊天啦。从任务管理器能看到,核显基本满载,用了 7.2G 主机内存,模型的 token 生成速率约为 10token/s,日常使用对话很流畅。

NPU 未来可期

Ultra245K 的 NPU 是个大亮点,虽然目前因为太新,部署有 bug,但我已经提交给 Intel ipex-llm 了。按照他们的更新速度,预计下个月左右就能用 NPU 进行模型推理和部署,到时候性能肯定更厉害。

总的来说,用 Ultra245K 搭建 DeepSeek 本地模型,性价比超高,适合想拥有自己本地 AI 助手的朋友。要是在搭建过程中有问题,欢迎在评论区留言,咱们一起交流!